Ollamaは、Llama 2やMistralなど、さまざまな言語モデルをサポートする強力なローカル実行の大規模言語モデル(LLM)フレームワークです。現在、LobeVidolはOllamaとの統合をサポートしており、LobeVidol内でOllamaが提供する言語モデルを簡単に使用してアプリケーションを強化できます。

このドキュメントでは、LobeVidolでOllamaを使用する方法を説明します:

Ollamaは、Llama 2やMistralなど、さまざまな言語モデルをサポートする強力なローカル実行の大規模言語モデル(LLM)フレームワークです。現在、LobeVidolはOllamaとの統合をサポートしており、LobeVidol内でOllamaが提供する言語モデルを簡単に使用してアプリケーションを強化できます。

このドキュメントでは、LobeVidolでOllamaを使用する方法を説明します:

macOSでOllamaを使用する

1

Ollamaをローカルにインストール

macOS用Ollamaをダウンロードし、解凍してインストールします。

2

Ollamaのクロスオリジンアクセスを許可する設定

Ollamaのデフォルト設定では、起動時にローカルアクセスのみが設定されているため、クロスオリジンアクセスとポートリスニングには追加の環境変数設定

OLLAMA_ORIGINSが必要です。launchctlを使用して環境変数を設定します:3

LobeVidolでローカル大規模モデルと対話する

次に、LobeVidolを使用してローカルLLMと対話できます。

WindowsでOllamaを使用する

1

Ollamaをローカルにインストール

2

Windows用Ollamaをダウンロードし、インストールします。

3

Ollamaのクロスオリジンアクセスを許可する設定

4

Ollamaのデフォルト設定では、起動時にローカルアクセスのみが設定されているため、クロスオリジンアクセスとポートリスニングには追加の環境変数設定

OLLAMA_ORIGINSが必要です。5

Windowsでは、Ollamaはユーザーおよびシステムの環境変数を継承します。

6

OLLAMA_ORIGINSを編集または新規作成し、値を*に設定します。OK/適用をクリックして保存し、システムを再起動します。Ollamaを再実行します。7

LobeVidolでローカル大規模モデルと対話する

8

次に、LobeVidolを使用してローカルLLMと対話できます。

LinuxでOllamaを使用する

1

Ollamaをローカルにインストール

2

以下のコマンドでインストールします:

3

curl -fsSL https://ollama.com/install.sh | sh

4

または、Linux手動インストールガイドを参照することもできます。

5

Ollamaのクロスオリジンアクセスを許可する設定

6

Ollamaのデフォルト設定では、起動時にローカルアクセスのみが設定されているため、クロスオリジンアクセスとポートリスニングには追加の環境変数設定

OLLAMA_ORIGINSが必要です。Ollamaがsystemdサービスとして実行されている場合、systemctlを使用して環境変数を設定する必要があります:7

sudo systemctl edit ollama.serviceを呼び出してsystemdサービスを編集します。8

sudo systemctl edit ollama.service

9

[Service]セクションの下にEnvironmentを追加します:10

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

11

systemdをリロードし、Ollamaを再起動します:12

sudo systemctl daemon-reload

sudo systemctl restart ollama

13

LobeVidolでローカル大規模モデルと対話する

14

次に、LobeVidolを使用してローカルLLMと対話できます。

Dockerを使用してOllamaをデプロイする

1

Ollamaイメージをプルする

2

Dockerを使用することを好む場合、Ollamaは公式のDockerイメージも提供しており、以下のコマンドでプルできます:

3

docker pull ollama/ollama

4

Ollamaのクロスオリジンアクセスを許可する設定

5

Ollamaのデフォルト設定では、起動時にローカルアクセスのみが設定されているため、クロスオリジンアクセスとポートリスニングには追加の環境変数設定

OLLAMA_ORIGINSが必要です。6

OllamaがDockerコンテナとして実行されている場合、環境変数を

docker runコマンドに追加できます。7

docker run -d --gpus=all -v ollama:/root/.ollama -e OLLAMA_ORIGINS="*" -p 11434:11434 --name ollama ollama/ollama

8

LobeVidolでローカル大規模モデルと対話する

9

次に、LobeVidolを使用してローカルLLMと対話できます。

Ollamaモデルのインストール

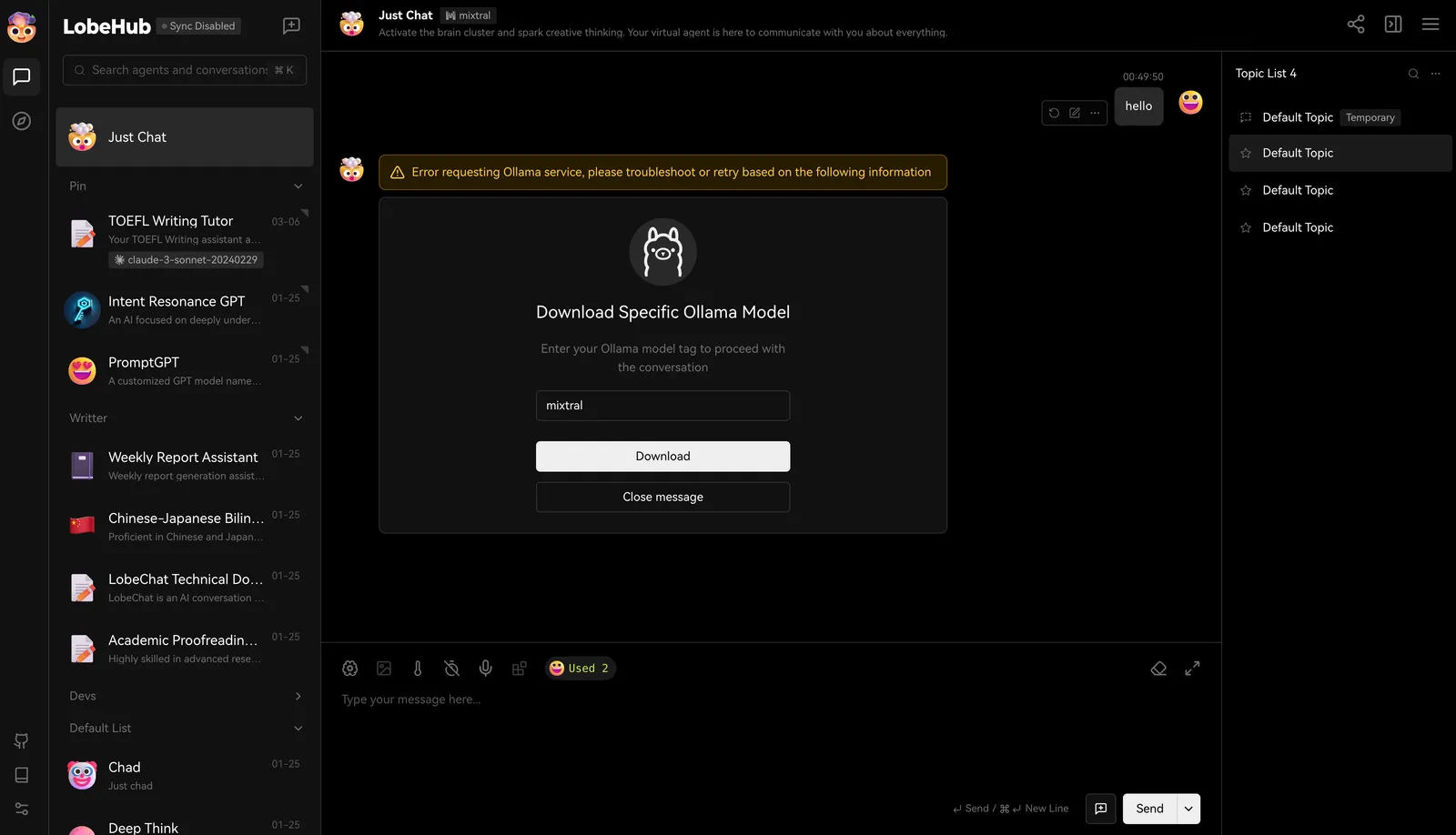

Ollamaはさまざまなモデルをサポートしており、Ollamaライブラリで利用可能なモデルのリストを確認し、ニーズに合ったモデルを選択できます。LobeVidolでのインストール

LobeVidolでは、llama3、Gemma、Mistralなどの一般的な大規模言語モデルがデフォルトで有効になっています。モデルを選択して対話を開始すると、そのモデルをダウンロードする必要があることを通知します。 ダウンロードが完了したら、対話を開始できます。

ダウンロードが完了したら、対話を開始できます。

Ollamaを使用してモデルをローカルにプルする

もちろん、ターミナルで以下のコマンドを実行してモデルをインストールすることもできます。llama3の例:カスタム設定

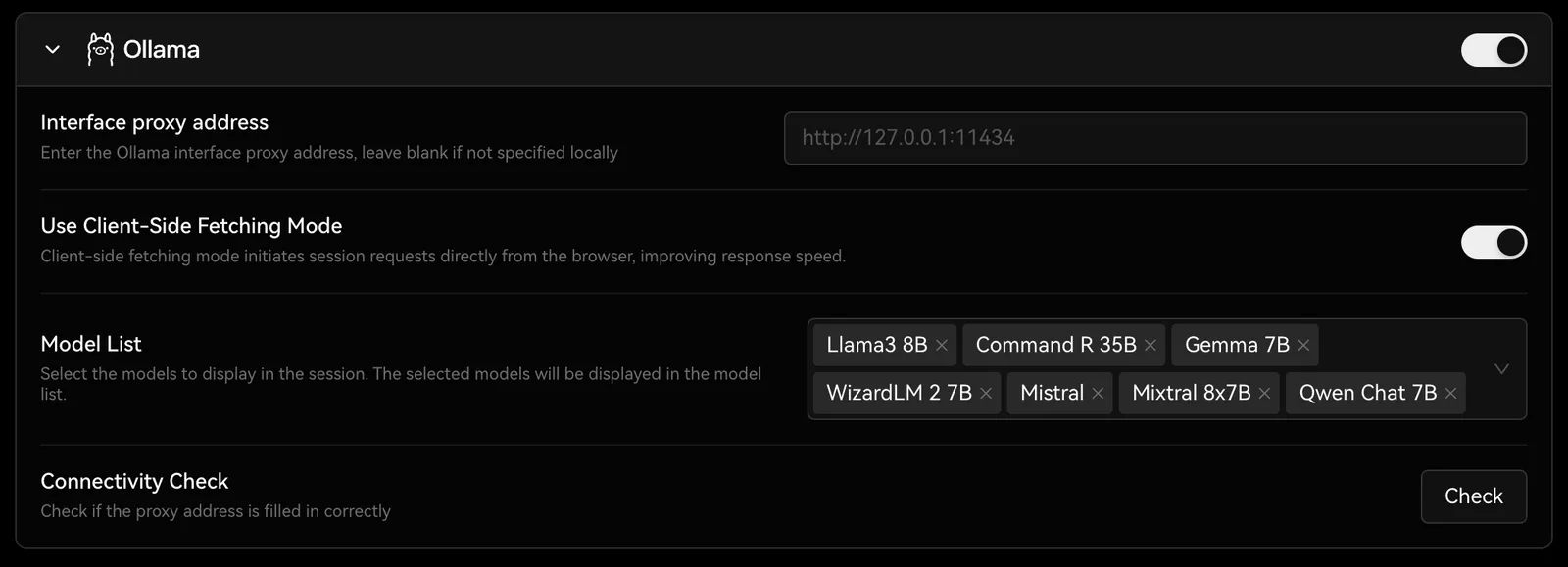

設定 -> 言語モデルでOllamaの設定オプションを見つけることができ、ここでOllamaのプロキシ、モデル名などを設定できます。

Ollamaとの統合にアクセスして、Ollamaとの統合要件を満たすためにLobeVidolをデプロイする方法を学ぶことができます。